00:02

はいどうも、kokorokagamiです。

当然です。

今週も1週間振り返っていきたいと思います。

はいはい。

先週話したリッスン、登録してみたんですけど、すこぶる良くてですね、

なんかいろんな意味でリッスンをメインにしようかなと思うくらい良くて、

改めてそのリッスンの良さをもう一度伝えたいなという感じなんですけど、

実際今回リッスン登録してみて、私たちが今まであげたポッドキャストを全部見れるようになった、

見れるというか聞けるようになってるんですけれども、

最新のもの、前回のものを見ているとですね、

今まで私たちがポッドキャストで配信していた記事、

何分にどんなことを話してますよっていうものに加えて、

サマリーとしてどんなことを話したのかとか、

何分にどっちがどんなことを話したのかっていう話者の振り分けだったり、

あとはここちょっと手動で設定したところもあるんですけど、

スポーティファイとか、最後の方でこっちもよろしくお願いしますって言ってる系のところへのリンクとか、

いろんな意味で動線の設計とかもしっかりされてて、

正直今までGitHubページでページ作ってやってましたけど、

いらなくなりつつあるなと思わされるような内容ですと、

ここまでしっかりしたものができるんだとしたら、

あんまりウェブページの方を更新する理由もないので、

アンカーとかスポーティファイポッドキャストとか、

そっちの方に移行するのもありかなと正直思い始めてたりします。

東田さんどうですか、ちょっと見てみて。

そうですね、ちまちまいじってみてはいたんですけど、

やはり言ってた通り、非常にページにアクセスした時に、

全体のまともにがいい、出来がいいという印象ですね。

最初にポッドキャストこれこれがありまして、

どの輪を見ますかというところで飛べると、

飛んだらサマリーがあって目次があって、切り分けられている。

しかもこれ全部自動で目次だったりサマリーだったり、

あと途中で中身でどの人が喋っているかというのも途中から聞けるというところで、

かなり今まで頭から聞くしかなかったポッドキャストというものを

聞きたいところだけ聞けるようになっている。

その動線がすごくしっかりしているというところで、

かなり今までより触感が違うなというところがかなり感動ですね。

あと和写の設定とかは一応自分で設定する必要はあるんですけども、

痒いところに手が届いているなといろいろ思ってまして、

例えば和写を設定した後に心鏡と東電がやってますという設定をすると、

次回から自動的に和写設定がこの2人が入りますというようになっているとか、

かなり和写分離もすぐやってくれるので、

ポチポチっとしてじゃあこっちが心鏡でこっちが東電ですと設定してしまえば、

だいたいどっちが喋っているかというのが本当のものの10秒くらいで設定できるというところで、

そのポッドキャストを作っている側としてもかなりロードが低い、

簡単に設定できてすごく便利だねというところで、

利用者、リスナーとポッドキャスト配信者両方の目線から見ても、

かなり完成度が高くできているというのがまさに素晴らしいなと思っています。

今の和写の分ける部分ですけど、技術的に結構すごくてですね、

皆さんは仕事で日本企業だと思うので、マイクロソフト365のTeamsを使っていると思うんですけど、

あのTeamsにも和写機能というのがあるのはあるんですが、

実は同じ会議室とかにいる人は区別できなかったりするんですよね。

何をやっているかというと、どのマイクインターフェース、

どの参加者から入ってきた情報かというので振り分けているので、

後遺質とかその辺で判断しているわけではないと。

ある意味、かなり明確に分かれたデバイスさということで和写設定を組み込んでいるので、

現実的な和写設定とは返りが生じうるんですけど、

今このポートキャストで和写設定は一つの音楽ファイルに対して文字起こししながら和写を分けられているので、

ちゃんとその音声データの中から2人の登場人物がいるなというのを後遺質とかから判断して振り分けできているというところが大変素晴らしいなと思ってますね。

そうですね、マジこれ謎技術ですねという感じですけども。

100%うまくいっているわけではなくて、

ところどころ、特にうちらみたいなめちゃくちゃ1人が長く喋っているところだと、

途中で切り替わっちゃったりしてはいるんですけど、

でも9割ぐらいはきれいにちゃんと分けられているというところで、

マジでこの謎技術すげえなという感じですね。

そうですね。

もともと文字起こししたらこんなことできるよねって話してた部分に対してのUIもしっかりあってですね、

文字起こしされるとやはり検索性が高まるよねとか、

過去の話している内容を思い出しやすくなるよねという話をしてましたと。

リスンではその検索機能がちゃんとついていて、各ポッドキャストの中に入ってからなんですけど、

そのポッドキャストの話一覧があるところの上の方に検索窓があって、

そこで特定のテキストを検索すると、その内容を話しているであろう回が全部表示できると。

で、大体どの辺でっていうのもちゃんと追っかけられるようになっているので、

過去にとびとびで話してきたことを追っかけ直すとか、

私たちが1年に1回年末年始とかにやっていた今年の振り返りとか、

そういったことが非常にやりやすくなっていて面白いなというところですね。

そうですね、そこら辺もやっぱり思っていたことが実現できているのがすごいなというところもありますし、

検索性の話でいうともう一つ感動したのが、

そのしゃべっている一文をリンクにして飛ばせるURLとして共有できる機能がついているんですよね。

YouTubeとかでも実はそういう機能があって、

YouTubeのこのチャンネルのこの動画の100秒から共有しますみたいなのができるんですけど、

そういうのが実装されているんで、

まじで長ったらしい私たちみたいなポッドキャストの途中から共有して話すことができるということが実現できていて、

まあ素晴らしいですねという気持ちでいます。

そうですね、正直会社とかでもこのポッドキャストで話してたあのことだなって言って、

ポッドキャストを紹介したくなるんですけど、

ただ1時間聞いてあの辺にありましたっていうのははばかられるので、

まあそういうことも裏では話してるんですけどね、

はははしか言えないっていう事情があったんですけど、

これができることによって今までそのポッドキャストを聞いてなかった人にも

いやポッドキャストでこんなことを話してるんですよって言いやすくなったなっていうのがありますね。

そうですね、まじで素晴らしいですねというところで。

はい。

こんだけよくされると本当にGitHubページとか自分たちでページを立てている理由が全くなくなっているので、

ちょっと廃止にしてもいいかなとか思ってます。

なのでちょっと今後更新とかの過程でもしかすると、

一時的に別のフォームに移る過程でフィードが変わったりとかして、

ポッドキャストの連続性がちょっと失われたりとか、

まあそういったことがあるかもしれないんですけど、

まあその辺の互換性を立てても移行するという決心もあるかもしれないので、

またその辺が決まり次第共有かなと思ってます。

はい、まあTwitterみたいに滅びるかもしれないけど。

滅びるかもしれないけど、

でもこれはこれにガン乗っかりしてても応援したいですよね。

そうですね。

そのくらい魅力的なサービスなので、

頑張っていてほしいなと。

マネタイズどうなっているんだろうなそういえば。

なんか今後その有料ライセンスというか、

有料機能追加版みたいなのをやりたいみたいなことをDiscordでなんか言われてたんで、

そこら辺が出てくるかもしれないですね。

はいはいはい。

なるほどね。

まあでも多少の、個人なんで数千円とかになるとちょっと厳しいですけど、

千円前後とか月額くらいだったら払ってでもなんか最新機能使わせてもらいたいって気になっちゃいますけどね、

これだけいいサイトだと。

そうですね。

応援の意味を込めてちょっと出してもいいなというレベルなので、

頑張っていってほしいと思いますというところでございます。

じゃあ枕渡しはそんな感じです。

本編の方いきたいと思います。

1点目。

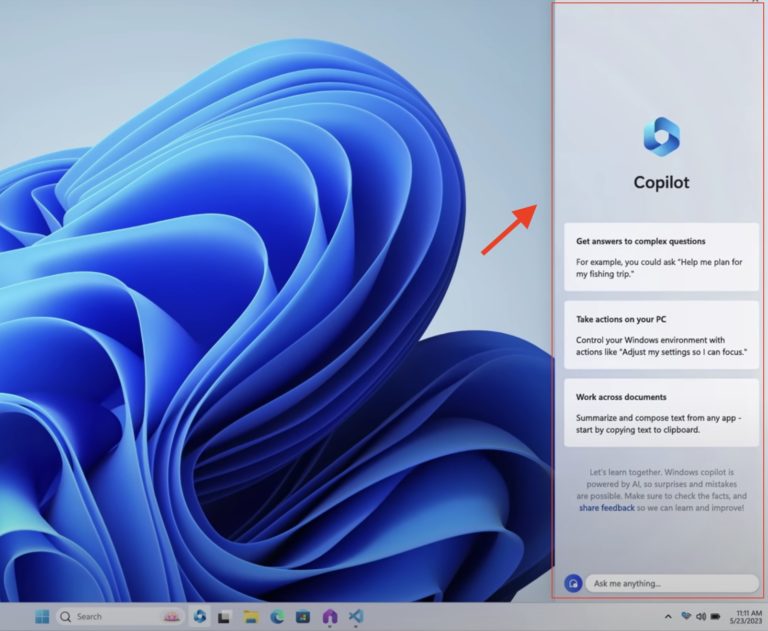

Windowsコパイロットの概要

Windowsコパイロット使い方やできることはAI搭載マイクロソフトOSを徹底解説ということで、

ヤキイモITブログさんの記事です。

Windows11にマイクロソフトコパイロットなるものが登場して、

私もそのプレビュー版を導入しているので実際に使ってみたという話なんですけれども、

まずこのマイクロソフトコパイロット、Windowsに搭載されたWindowsコパイロットなるものは何ができるのかって話から

軽くしたいと思います。

基本的には皆さんいつもWindows11の下側に検索窓があると思うんですけど、

その検索窓の右側にビングアイコンみたいなのが登場していて、

そこを押すと右側の通知とかカレンダーが出るようなエリア領域にコパイロットというウィンドワークが出ます。

これを出すとメインウィンドウは小さく狭められるので、

例えばブラウザとか開いている場合はその右側のコパイロット分だけ左側にちょっと小さくなる形になります。

できることとしてはビングとほぼ一緒な感じです。

ビングのAIの方で見たことあるかもしれないですけど、

より想像的にとかよりバランスよくより厳密にみたいな、

いくつかのパターンを持ってAIとしていろんなことをチャット機能を使って問い合わせて、

検索機能付きなので最新情報を含めていろんな調べ物ができますというものですね。

Windows OSの設定変更とファイル解析

チャットGPTとしての使い方をそのまましてももちろんいいんですけれども、

追加でできることとしてWindows OSの設定の変更等ができます。

デモではWindowsのテーマをダークテーマに変更するみたいなのがあって、

私もちょっとやってみたんですけど、

ちゃんとダークテーマに変更とかもできたので面白いですね。

一方ですごくマニアックな設定をお願いしたら分かりませんって返ってきたので、

できる範囲もかなり知れてるんだろうなという感じです。

主にはWindows 11で登場している最新機能とか、

そういったところに限定されているのかなという気はしてます。

昔ながらのユーザーグループポリシーを変更してないとできないような話とか、

すごくマニアックなそういう設定についてはちょっと難しそうでした。

もう一つできるのがファイルの読み込みと解析、説明というのができます。

チャットJPTでもPDFを読み込んで中身についてチャットするみたいな、

そういう話がありましたけれども、

Windows Copilotではドラッグ&ドロップでファイルを渡すと、

それの要約を説明してくれたりとか、

そのファイルについてのチャットができます。

私の方でもこれ試そうとしたんですけど、

コーパイロットの機能とマイクロソフトの期待

ちょっとドラッグ&ドロップで動く機能がちゃんと設定されてないので、

ちゃんと設定されてないのか直し方が分からないんですけど、

ドラッグ&ドロップするとブラウザーが立ち上がっちゃって、

中身をCopilotに食わせるというところになってないので、

だったらこの辺はちょっとデッキ次第という形にはなるんですが、

よくある今まで私たちが脅威したやつで言うと、

情報白書とか超長いPDF、政府から出ているPDFですね。

ああいったものを要約してもらったりとか、

そういったところで使ってみたいなと思ってます。

他アプリの起動もできて、

チャットでこのアプリを起動してくださいみたいなこともできます。

これについてもかなり限定的で、

Edgeとかはできるだろうなとかであったんですけど、

ゲームとかそのPCの中に入っている特別なアプリとか、

そういったものまで全部できるかというとまだまだなので、

今までのキーボードランチャーの代わりになるかと言われると、

そこまででもないという段階ですね。

なので今はまだプレビュー版ということもあって、

非常にいろいろ物足りないところはあるんですけれども、

体験としては新たにブラウザを立ち上げて問い合わせするという

2段階を踏まずに即問い合わせというアクションが取れますし、

Windows周りの設定についてはとりあえずBingに聞こうかという気にもなるので、

非常によいんじゃないかなと思います。

チャットGPTとかとの積み分けで言うと、

GPTのモデルとしての賢い部分はチャットGPTにお願いして、

Windows上におけるちょっとした作業だったりとか、

ちょっとした情報収集についてはBingが手順含めて早そうだなというところです。

これによって一番影響を受けそうなのがGoogleが出しているBirdで、

BirdはGoogleのページに行かないといけないのはBingも一緒だったんですけど、

Birdの場合、チャットをしてからそのレスポンスを得られるまでの速度が非常に速くて、

パッと調べるんだったら正直Birdが一番速いよねっていう世界だったんですけど、

ネイティブアプリとしてコパイロットが組み込まれてしまうと、

やはりその速度には勝てないよねっていうところがあるんで、

またGoogleが厳しい状態に立たされているなと思いつつ、

いいアップデートなので、皆さんの環境で導入されることがあったらぜひ使ってみてくださいという話です。

はい、確かにWindowsとの組み合わせが強力ですねという感じだと思いますね。

聞いていたところではWindows11機能へのフィッティングというか回答性が高いという話で、

それは当たり前といえば当たり前なのですけれども、

個人的には古い機能の方が深い階層に行ってどこ行ったかわからなくなるので、

回答してくれると嬉しいなと思って聞いていました。

古い機能は古い機能で、何かしらの制約の問題があって、

コパイロット側からいじりにくいとかあると思いますので、

難しいとは思いますけどねとちょっと思いながら聞いていたところですね。

さっき言ってたドラッグ&ドロップがうまくいかないとか、

そこら辺は今後改善していけばいい話だと思いますけど、

コパイロットに頼り気になると逆にそこでダメだったので、

もう一回最初から修道でやり直し、手順をやり直しとかなってしまうと、

ちょっと面倒くささが出ちゃいそうな気がするんですが、

そこら辺、食感どうだったでしょうかというところが聞きたいところですね。

そういう意味だと、コパイロットで物事が解決できる率はまだ20%くらいだと思います。

なので、おっしゃる通り成功体験が積み重ならないせいで、

正直使わなくていいかってなるのはなると思います。

そういう意味でもまだプレビュー版かなっていう感じですね。

そこ頑張ってくれないとWindowsのヘルプみたいに、

どうせわからんからGoogleで聞こうみたいになってしまうと、

ちょっともったいないなというところですね。

現状はそうでありつつ、最終的には角度が上がっていってもらいただきたいなというところ。

角度が上がっていった段階でいうと、Googleがさっき言われたようにかなり厳しくなるので、

というかもう勝ち目がないなという状態になるので、さあどうしたものかという気がするんですけども。

やっぱりGoogleがOSを作るしかないのかなというところになるのか。

でもシェア取れない、今から取るのかという話になるでしょうけど。

そうですね。Chromebookとかでタブレット業界を再興させようとはしてますけど、

それもそんな高いシェア取れるわけじゃないので。

そうですよね。結局シェアが取れてないという現状からするとなかなか難しいなとGoogle側としては思う感じですね。

そうですね。Windowsコーパイロットで将来的なアップデートに期待される部分としては音声認識ですね。

先ほどのBirdは音声認識あるんですけど、BingとかChatGPTにはデフォルトでは音声認識入ってないですと。

Windowsコーパイロットでなぜ音声認識を期待するかというと、

もともと音声認識によるWindowsの操作というユーザーインターフェースがWindowsには用意されてるんですよね。

ただそれって結構操作性が悪くて、かなりWindowsが期待している正確なワードでしゃべってあげないとなかなか思い通りに動かせないというところがあって、

どういうふうにしゃべる、どうWindowsを期待通りに操作できるのかという学習要素がかなり高めで、

健常者からするとすぐ諦めてしまうようなインターフェースだったという背景があります。

コーパイロットに音声入力がついて、そこである程度人間のしゃべるワードチョイスの広さというか、

そのブレ幅というのを吸収して、実際Windowsにとっての音声入力のインターフェースに加わせるとか、

そういったことができると、もっと操作性が上がるだろうなと思ってます。

皆さん、キーボードとかマウスとかでブラウザーとか操作したり、ウィンドウ切り替えたりとかしてると思うんですけど、

やっぱり指的にもストレスになるのが、そのウィンドウを動かしたりとか最小化したり最大化したり切り替えたりっていうところが非常にストレスで、

一番無駄な作業になっていることが多いと思うので、そういったのが音声入力ができると、

もっとマイク常備で口と手を動かして仕事をすることができるようになるので、いいなと思ってますね。

そうですね、確かに。そこら辺、今まで全然使えてなかったところがうまくいくと、音声認識という、

昨日は結構前から乗ってたけど、うーんってところが一皮向けて使いやすくなる。

Windowsコーパイロットの将来への期待

そうですね、その未来が来てくれるといいかな。でもなんか結局音声認識、会社で使うかって言われたら使わないよねっていうところも。

会社では使いにくいですね。在宅ワークではガンガン使えるんですけど。

あー、なるほどね、確かに。

いやー、やりたくなるのが、例えばさっきまで開いてたウィンドウに戻してとか、

今割り込みで別の作業に行ったけど30分前にやってた状態に戻りたいんだけどとかいうこととか、

そういうことが結構あるので、そういうのを音声とかチャットでパパパッと戻してやれたらなと。

カセオとdesktopとかもあるけど、やっぱり人間の頭であれを管理させるのは限界があるっていうのが現状だと思うんで、

ああいうのもコパイロットにスナップショットとして加わしておいて、それが大体どういうものかを自由度高く解釈してもらって、

昨日やった作業に戻りたいで、同じようにファイルとかアプリ全部開き直してくれるとか、そういったことをしたいですよね。

確かに、それは便利そうですね。

なので、コパイロットのすごく自由度の高い解釈能力っていうのをフルに活かしたアプリケーションがWindowsに入ってくることを期待して、今後のアップデートにも注目していきたいなという話です。

デジタル帳の素材集の無償公開

では2点目、私の方から窓の森さんの記事です。

デジタル帳、公式のイラストとアイコン素材を無償公開、400種類以上商用化というタイトルの記事です。

デジタル帳は6月27日、行政手続をわかりやすく表現するためのイラストレーション素材とアイコン素材を無償公開した。

クレジット表記なしで商用での利用も可能。無料デザインツールフィグまでも利用できる。

この素材集はこれまで政府として公式に配布する専用の素材がなく、地方自治体や民間サービスで独自に製作する必要があるという問題を解決するために製作された。

この素材が広まれば、製作者によって表現がバラバラになるという問題も解決しようされるであろう。

素材集はイラストレーション素材とアイコン素材に分かれている。

いずれも大振りの曲線を描いて印象を柔らかくしたり、一つのアイコンに複数の要素を詰め込んで複雑にならないようにするなど、

一目見たときにわかりやすい、自分でもできそうという印象を持ってもらえるように検討を重ねているという。

手続の方法を伝えるイラストレーション素材は全74種類。

行政文脈のコンテンツを伝えるアイコン素材は全360種で、SVG方式とPing方式が選べる。

いずれもPDF形式のガイドライン付きで、サイズや使用例に加え、これらの素材をもとに新しい素材を製作する際の注意点などが案内されている。

ということで、政府公式がこういう素材を出してくれるのは非常にありがたいなというところですし、

今時のモダンなアイコンをちゃんとお出ししてくれているので、分かっているなというところで、機会があったら使ってもいいのかなというところでの紹介です。

はい、もう300点満点ですね。

ネジサル庁がやる仕事としては本当に素晴らしいと思います。

まずこういうアイコンとかっていうのが世の中からどう受け止められるかっていう話からすると、

私たちAndroidのスマートフォンとか、普段公共の駅とかで見てるアイコン、

もうあれを見ればトイレだって分かったり、これを見ればメニューだって分かったりっていうコンテキストありきの解釈があって動けるっていう状態がすでに作られているわけですけれども、

それっていうのがある特定のアイコンに意味付けしてそれを使い続ける。

いろんな場面で登場させ続けるということによって、社会にいる人たちがアイコンを見るだけでおおよそのベクトルだったりカテゴライズっていうのを理解して、

今までの最も多い事例に紐づけてこうだろうとすぐ解釈できるっていうメリットがありますと。

プレゼン資料とか何かドキュメントを書くときには、そのコンテキストを伝えたいのであればそのコンテキストに最も合致したアイコンを登場させることで、

最もブレの少ない伝える力を得ることができるということで非常にアイコンというのは社会実装上かなり重要なものになってますと。

それが公開されるということは共通的なコミュニケーションというのがより加速するということなので、

ちょっと期待がありすぎるかもしれないですけれども、いろんな場面でのDX推進の底上げにつながるだろうという期待感がありますと。

もう一ついいのがイラストレーションも今回ついていて、行政でしか持ってないようなイラストの公開もそうですし、

行政が推進するDXにおけるワークフローの登場シーン、特にQRコード読み込みとかポスト投函とか、

そういったところのイラストがついてるっていうのが非常に良くて、ユースケースとアクションのイラストって結構書くの大変で、

相手のコンテキストに合わせて書くっていうのもかなり難しいので、大体文字で表現しがちだったりするんですけれども、

そういったのもイラストになることでもっともっとより多く伝えていけるだろうと。

そのDXでいろんなソリューションがあっても、実際撮るアクションというのは割と限られてたりするので、

そういったシナリオシーンが絵として共通化されるっていうのは、またこれも非常にインパクトの大きいことかなと思ってます。

そうですね。行政のお手紙とかで結構使用頻度が高いものが多分集まってると思うんですけども、

最初の方で言ってたようにアイコンというか、共通の毎回使ってるからこれは行政文章でこういう意味だっていう、

印象付けというかブランド性みたいなのがこれを使い続けることで出してくれると非常に良いのかなと思ってます。

この記事でも最初の方にありましたけど、地方自治体で独自に作ったやつとか裁量性マジであんまないですし、

民間サービスというか、某アイコンというかイラスト公開サービスとか、行政とかでもよく使われているというのは目に見せますけど、

あれも結構民間サービスに乗っかっちゃってるので、行政文章らしさがあんまりなくなってるみたいなところもあるとは思うので、

そういう意味でこれを使い続けて行政のブランド力みたいなのが上がってるといいなと思いますね。

そうですね。ああいうものを使っている資料で一番困るのがですね、そこでイラストを、

イラストやって言っちゃったけど、そういうものを登場させるとイラストの印象の方が強く残っちゃって、

本来伝えたいそのイラストに吹き出しで例えば何か書いてあるとか、下に説明書きが書いてあるとか、

そっちの文字情報がやはり伝わりにくくなってしまうというデメリットもあったと思うんですよね。

そうですね。

注意を引けるという意味で良かったのかもしれないですけど、

アイコン、今回のSVGとかPingアイコンというのはフラットなデザインで基本線ベースで色づけされていないものなので、

その文字情報と比べて特別大きなインパクトを与えるものじゃないので、

本来やはり伝えたい部分にちゃんと強調できるという良いところがあるんですよね。

文章を例えば書いているときに一番のキーメッセージは赤くしたり太文字したり大きくしたりという工夫を仮にやったとしても、

隣にあるイラストがすごく凝っててカラフルだとそっちの方が目に付いちゃうという状態だったんですけど、

アイコンの方はシンプルに黒線だけで置いてあって文字列の方で赤字とか強調表示してあれば、

ちゃんとその赤字の方が強調されて伝えられるので、

本当にイラストとその文字の組み合わせという伝える能力を残したまま、

本来伝えるべきことにフォーカスさせられるという効果もあるので、

非常に私はアイコン素材というのを推してますね。

そうですね。

そういう、本来のアイコンとしての使い方に合ったアイコン性っていうのもちょっと考えられてる感があるんで、

そこら辺いいなと思いますね。

そうですね。

あとは、これで成功してもらってアイコン素材を充実させていってほしいなと思ってるのと、

こういうアイコンって結構流行りすたりというか、

フラットなデザインも数年経てば何かこう、芋臭くなるみたいなところがあるので、

そういう更新もめげずにやってくれると嬉しいなと思いますね。

そうですね。そういう意味だと逆に今は前向きに取られてもいいかなと思っていて、

マテリアルデザインアイコンと言われるMDIアイコンというのがフリーでOSS化してるんですけど、

そっちは割と長く使い続けられてますね。

今のデザインの変更はボタンの枠をどう表現するか、どう浮かしたりしてボタンだと認知させるかとか、

その形状の方にフォーカスが当たってるかな、デザインのアップデートが。

アイコンはアイコンとしてちゃんとそのまま使い続けて、

元々あった伝える力を活かしつつ、いかにそれが押せるものなのかどうアクションできるものなのかっていう、

そのアイコンに対するユーザーに期待するアクションをどう表現するのかっていう研究の方が今デザインのメインになってるので、

そういう意味だとこのアイコンというのは割と息が長そうだかなと思ってますね。

じゃあいいですね。その文脈に則ったアイコンができてるってことなんで、

今後ずっと使い続けていってもらって、とりあえずその文章を制作するときはこれだよねっていうところまで行ってもらえると、

非常に日本としてもいいんじゃないでしょうかという国レベルの話になりますけど。

そうですね。あとはWeb屋さん的に嬉しいのが、SVGとPingの両方サポートしてるのは最高ですね。

なるほど。そこら辺分かってるなという感じで。

分かってますね。SVGはご存知の通りですけど、どんなフォーマットでも解像度がガビガビにならないので素晴らしいフォーマットですし、

Pingでも特定の解像度1個が置いてあるわけじゃなくて、サイズが3種類くらいあるんですよね。

このサイズ3種類って何のためにあるのかっていうと、

端末の画面サイズと解像度のばらつきを抑えるためのものなんですよ。

例えばPCで4Kディスプレイで見てる人とスマートフォンで見てる人が同じ解像度のアイコンで見ると違和感が出るんですよね。

高すぎても低すぎても解像度って気持ち悪くなっちゃうので。

Webページのサイト構築技術として、今開かれているページの解像度情報から最適な解像度の画像に差し替えて表現するということがよくあります。

これはWeb画面だけじゃなくてAndroidのネイティブアプリ作成でも同じようなことをやってます。

そういった意味でも解像度分けされたアイコン素材っていうのが用意されているのは非常に素晴らしいですね。

そこら辺やっぱりちゃんと分かってる人が作ってるんだなという印象を持ちますんで。

そういう意味でもだいぶ好印象なところがありますね。使いやすそうな感じ。

そうそうそう。デジタル帳すごい。最近のデジタル帳すごい。

素晴らしいですね。最近できたところですけど。

そんなところでした。

じゃあ次行きます。

Microsoft 365 Copilotの概要

Microsoft 365 Copilot初期設定方法が公開されたので確認してみたということで、クラウドネイティブブログさんの記事です。

Microsoft 365 Copilotの機能と使い方

Microsoft 365 Copilotとは、GPT-4をTeams, Word, Excel, PowerPoint, Outlookなどのオフィスアプリケーションに組み込み、ユーザーの生産性を向上させることを目的としたソリューションです。

従来我々が利用していたMicrosoft 365のアドオンライセンスとして登場予定で、Microsoft 365 ECまたはMicrosoft 365 E5を利用していると購入いただけます。

Microsoft 365 Copilotは、組織のMicrosoft 365上のデータを参照した上で、ユーザーに応答を返すことができ、デモビデオを見る限り以下の使い方が想定されています。

Teamsでは会議の議事メモを作成したり、チャットで指示を与えることでCopilotに組織のデータを探してこさせて、予約して表示できたりします。

Wordは文章作成、編集、予約、作成を支援します。

短いプロンプトを与えるだけでCopilotは必要に応じて組織全体から情報を引き出してドラフトを作成します。

Excelではデータ分析やその後のグラフ化の作業を支援してくれます。

自然言語でCopilotに質問することで相関関係を明らかにしたり、何かあった場合のシナリオを提案したり、新しい数式を提案したりします。

PowerPointではユーザーのアイディアを鮮やかなプレゼンテーションに変えるお手伝いをしてくれます。

Microsoft 365 Copilotのセキュリティ上のリスク

既存の書類をスピーカーノートとソース付きのスライドに変換したり、シンプルなプロンプトやユーザー自作のアウトラインから新しいプレゼンテーションのドラフトを作成することができます。

Outlookでは返信の下書き等を書いてくれることでメールの整理にかかる時間を減らし、より効率的にコミュニケーションを取ることができます。

これらのMicrosoft 365に対するアップデートがどのように導入できるのかという手順書のみ先行して公開されたという話です。

その辺の有効化とライセンスの当て方、あとはどういう権限のものがどうなるのかというところについて手順書が公開されたわけですけれども、

この記事でポイントとされているのは、その手順書のみがなぜ先行公開されたのかという点です。

このブログの方曰くにはなってしまうんですけれども、

Microsoft 365のアクセス権限コントロールが正しく環境整備されていないとコンフィデンシャル的なリスクをはらんでいるものだからというところに尽きるんじゃないかとコメントされています。

どういうことかというと、SharePoint、Microsoft 365を使っている場合での共有フォルダなるサービスですよね。

SharePointにいろんなファイルが挙がっています。OneDriveにも挙がっています。

それぞれのファイルは必要に応じて、必要なチーム、必要な人とファイル共有しているわけですが、

多くの人がものすごい権限範囲の広い組織、サイトの下にポンポンファイルを置くか、

ファイル共有のたんびに社内組織にいる全員にアクセス可能みたいなすげーでかい権限をつけてサクッと共有するみたいなことをして、

権限を厳密にして運用したりファイル交換したりっていうルールを持たずに好き勝手にやっているということが起きていて、

その状態で今回のCopilotを有効化してしまうと、人間ではなかなかそんなファイル普段は見えないからリーチされないはずなんですけど、

Copilotがうまく全部を検索できてしまうがために不必要に高い権限が設定されているファイルの中身を探索して回答してしまうと。

つまり新人1年目の人がサクッとCopilotを使って何か検索すると、

マネージャー間で取り交わしている組織のKPI情報とか売上目標みたいなそんなおいおいというような書類も混ざって返答が返ってくる可能性があって、

今まで組織のガバナンスのルールがダメダメだったところを見事にCopilotが検出してくれちゃうということが起きかねないので、

こういう機能のものだから今から注意されるなり導入ができるのかできないのかとか、

そういう議論を始めておいてくださいねということを言うためにこういった手順書を前もって出してきたんじゃないかというのがこの人の意見ですと。

私もそこについては非常に共感するところでして、

Copilotに加わせられる情報もかなりきれいにしないといけない問題はいろいろあって、

SharePointの中で古くなったファイルの運用もあまり是正されていないという問題がありますと。

例えば2019年、2020年とか古くなったファイルどうしますかって言ったらいつか触るかもしれないからとりあえずSharePointに放置しっぱなしみたいなことがよくあるわけですけれども、

例えば2020年にはマネージャーだったその人は現在はマネージャーではなくなっているとか別の部署に行っているみたいなことが起きるわけですけれども、

じゃあ今この誰々さん、誰々マネージャーの今の役職、職場は何ですかって聞いたときにCopilotからするとどの情報を元にどう回答していいのかわからなくなるということで謝り率が高くなってしまうとか、

そういったそもそも正答を得られない、期待する結果をCopilotから得ることができないという環境もあり得ると思っているので、

私たちはまだまだマイクロソフト365のCopilotが登場したからといってすぐ使える状態になるので、

本当にこのマイクロソフト365に乗っかって加速していきたいのであれば今からいろんな働きかけをして、

365が使えるサイト一式はここだみたいな、そこの中であればちゃんと気持ちよくCopilot使えますよみたいな環境作りとかをしてみて、

試験運用できるとか、そういう準備を始めておかないといけないかなと思っています。

そうですね、という感じがしますけど、まず一つ突っ込みで、さっき話したのはWindows Copilotで、これはマイクロソフト365 Copilot、

Copilotいっぱいありますね、というところですけど、今回の話はマイクロソフトの365、いわゆるOfficeとかTeamsとかそこらへんに対してCopilotが乗ります。

乗るんですけど、その権限回りとかのチェックを先にしててくださいねというお話と。

そうです。

言われてみると確かにその通りですけど、何て言うんですかね、今言われてた先にやるのは確かに正攻法というか正しいんですけど、

そこまで議論しきれる会社は果たしてどのくらいあるのかなっていう。

ないんじゃないですかね。

聞き忘れるなというところですね。

でも職務としてこういうAIサービスを使うような会社はやらんとあかんかなという気はしているんで、できるといいなとは思います。

けど、どこから買って使おうかなと思っているレベルの会社だと、他のツールでもよくありますけど、

例えばアイトリブリの企画とかが出てたとしてもガン無視で古い企画のまま使ってるとかゼラゼラにあるんで、

それと同じ扱いになっちゃいそうだなみたいなところがちょっと聞きながら思ってましたね。

そうですね。

各IT部の人たち、各日本企業のIT部の人たちはこんなニュースを受けて、

早くマイクロソフト365が出た時に動けるようにしろよっていう指示が出てるはずなんですけど、

おそらくほとんどの企業は現実的に無理っていう回答になるはずなので、

無理なら無理でどうすればできるのか、何があればそこには導入できるのかとか、

そういう別の打ち手を考えられるようになったほうがいいのは間違いないですね。

まあでも、まあまあそうですね。

その打ち手も何かでも難しいなと。

結局、よく知ってるか責任を持つ部隊が危機組織に合わせて運用せざるを得ないというのは現実界かなとは思うんですけど。

その設定すらコパイロットがやってくれるのであれば一番いいとは思いますけどね。

そうですね。

まあ想定できる導入ケースはもうプロジェクト単位でサイトを切ってるケースですね。

その組織全体でサイトを切ってる場合だと、

その全てのユーザーが全ての業務に対してコパイロットが認識しやすい形式だったりとか、

そのライフサイクルでやり取りするっていうのは現実的ではないので、

あるプロジェクトの中では必ずデータを正規化しておきましょう。

で、重複した資料は当たり前ですけど作らないでおきましょう。

開発資料重複した資料作ると大体怒られるじゃないですか。

そういうあるプロジェクトが始まってから終わるまで、

自分たちが作ったMicrosoft 365資産に対して最適化するということができるんじゃないかなと思っていて、

それの一番のメリットはチームメンバーが変わったときの教育コストとあったりとか、

あとは納品研修周りでお客さんに伝える、そのままMicrosoft 365のファイルのまま伝える場合に、

何か質疑があった場合にこのコパイロット経由でそれに答えられるようにするとか、

そういったケースかなとは思うんですけど、

そうすると社内DXにはなかなか寄与できないのでちょっと悩ましいところはあるんですけど。

まあでもそういう運用、要は社員全員が知識を持って運用できているようにして、

最小単位の組織ごとで成立させるのが成功法というか、

それ以外やると結局アクセス権限がうまくいってないので面倒くさいってなってしまう。

未来が見えるんでそうするしかないよねという気がしますね。

そうなんですよ。アクセス権限が正しくないファイルがコパイロットが見える範囲にポンと置かれたら止めなきゃいけないんですよね、コパイロット。

それがきつすぎるんですよね。

なるほどね。

じゃあちょっと使うにしてもかなりコストをかけていく必要があるなと思いますけど、

やっぱり使うことでだいぶ生産性が上がるっていうのはもう見えてる話なんで、

もちろん。

頑張って使っていきましょうというところですね。

最小限として社内データのアクセス全禁止して使ってもそれなりに使える気がしますけどね、メールの返信とか。

確かにそうですね。まずは使いたいところ最小単位だけの設定してからみたいなところが現実的ですね。

はい、以上です。

では次の話。

浸水センサーの実証実験開始

KCCSとマスプロ電工シグフォックスを活用した浸水センサーを国土交通省の実証実験で設置開始というタイトルのKCCS。

近年豪雨による浸水被害や河川の氾濫が頻発しており、

堤防ノイズや決壊の状況、周辺地域への浸水状況などをいち早く把握し、

迅速に災害対応を行うことが求められている。

また、流域内で活動を行う様々な企業等においても、各社の店舗や事業施設に対する災害時対応の迅速化に必要な浸水状況の速やかな把握や、

住居等の浸水被害に対する迅速な保証金支払い等の企業活動に必要な浸水データを入手する仕組みへのニーズが高まっている。

国土交通省水管理国土保全局では、浸水の状況を面的にいち早く把握するため、

小型低コスト長寿命で多数の箇所に設置が可能な浸水センサを、

国・地方・自治体・企業等の流域内のあらゆる関係者で連携して設置し、

検知情報を集約するプラットフォームを整備するなど、浸水状況をリアルタイムで収集・共有する仕組みの構築を目的として、

令和4年度よりワンコイン浸水センサ実証実験の取り組みを進めている。

浸水センサーの特徴と利用価格

京セラコミュニケーションシステム株式会社とマスプロ電工株式会社は、

ワンコイン浸水センサ実証実験に参加しており、

低価格・低消費電力・長距離伝送を特徴とするグローバルIoTネットワークSIGFOXを活用した浸水センサを共同開発し、

6月から実証実験に参加するモデル自治体等に設置した。

同センサは中継機等のネットワーク設備や設置工事が不要な小型の端末で、

結束板の等で用に取り付けることができる。

コインテンチで約3年間稼働し、外部電源からの給電も不要だ。

同センサを浸水想定エリアに設置することで、

ここの交通省が提供するアプリケーション画面上で浸水箇所・範囲が把握可能になり、

迅速な災害対応や地域住民への情報発信に活用できる。

今後、同センサは北海道・埼玉市・京都市など複数の自治体で設置する予定としている。

なお、利用価格は同センサ本体が1台当たり3900円、通信費が1台当たり年額500円からとなっている。

LPWAの課題と設置台数の限界

アプリケーション利用料が発生するということで、

昔から言われているこういう置きっぱなしセンサーあったらいいよねというのがまた出てきましたというお話です。

実際管理どうするんだみたいな話が結構あって、なかなか普及が難しいなと思っていたところで、

これもそういう面もあるんですけど結構いいなと思ったのは、

浸水したかどうかというゼロイチ判定。

なのでセンサーのドラフトとかで管理があまり必要でないというところとか、

家が浸水してしまったので保険金が欲しいみたいなのは今結構写真を撮ってどうのこうのとかで大変らしいので、

そこらへん活用して、例えば保険会社が配布してくれる、

今の車にカメラを取り付けて保険金を自動的に事故が起こったカメラの情報を元に支払うとか、

そういう用途と同じような用途で使ってもらえると結構流行るかなというところがいいかなと思ったのが紹介です。

なかなか難しいなというところで、ネガティブな気持ちにもなってしまうんですけど、

まずSIGFOXの存在なんですけど、

LPWA、長距離無線の企画で日本国内では強セラだけが独占して展開権限を持っている企画ですね。

なのでこのSIGFOXの企画がどれだけ普及するかはもう強セラにかかっているというものです。

2016年に独占を決めて現在までニュースを聞かれた通りの普及力で来ているというのが現状です。

その上でLPWA自体が悪いものではないんですけれども、

LPWAの特徴に一つの矛盾があって、その課題がいつまで経っても解決できないというところがあります。

それがですね、LPWAはその普及性と一般公客、D to Cみたいな展開ができていないところから、

無線モジュールの単価が全然下がらずに、どれだけ頑張って展開しようとしても、

一個一個のセンサー単価というのが非常に高くなりがちです。

長距離飛ばさなければいけないので、それなりの送信電力も必要というところもあります。

一方でLPWAはすごく長距離無線ができるので、一つの受信アンテナに対して多くのセンサーを地域にばらまいて、

一度にデータ収集をするというところがメリットな無線になるんですけれども、

その端末の価格が下がりきらないというところで、設置台数に予算的な限界がすぐ来てしまうという課題があって、なかなか難しいと。

今回のセンサー1.0で見るのは大変良いんですけれども、1.0で判断するというそのシンプルさこそ大量に起きたいはずなんですよね。

むしろ数を多くして、あるセンサーが多少止まってようがメンテナンスが遅れてようが、周辺の1.0センサーが生きていればそっちでリカバリできるくらいの、

そんなノリの設置をした方が多分運用上は非常に有用なんですけれども、

単価が下がりきらないというところがやはりボトルネックになっているのかなと。

このセンサーも4000円というところで、ただ1.0を判定して無線で送るだけの機器としては非常に高価かなという気もしています。

先ほど言っていた家の状態をモニタリングするLPWA系無線ですね。

こちらについては現状Y3という規格がメジャーになっていて、水量系とかその辺のセンシングデータについてはY3でやっていることが多いです。

シグフォックスでこれをやってどこまでその複裕力とか社会実装力というのを持ちながら進められるのかというのは、

相変わらずポジティブにはなれないんですけれども、活動自体はいいかなと思っていて、

この前東電さんが河川防災マップだったかな、川の防災マップだったかな、見せていただいたと思うんですけど、

あれではやはり地方のすごい小さな川だったりとかいうのはあまり測定が及んでいないというか、

カメラも置かれていないし水量系もなかなかない。合流とかリスクの高さのところにはやはり集中して置かれているんですけど、

昨今の豪雨、先週の梅雨の豪雨もそうでしたけれども、あまり今まで想定していなかった河川の氾濫まで起き出してはいるので、

そういったところにまで展開しようと思うと、もっと展開力のある河川水センサーみたいなのが求められているというのは事実だと思うので、

アプローチというか、やりたい社会実装方針は全然悪くないなと思うんですけど、なかなか技術屋さん目線的にはぐぬぬって思っちゃうみたいな感じですかね。

そうですね、という感じがあって。

でも共生らさんとしてはこれで頑張っていくとしてるんで、これで出してるという感じはあるんでしょうねというところで、

市場としては競合製品がいろいろあったほうが選択肢が増えるので、

最終的に顧客側としては選びたいものを選べるという意味ではいいのかなと思いましたね。

あとそうですね、さっき言った河川用とかはどうなんですかね。

確かにヤマゴックとかだったらこういうボタン電池で駆動するとかの方が設置はしやすいんでしょうけど、

そういうのって確実性?結局メンテナンス性が必要なんじゃないかなと思っていて、

それを考えるとボタン電池とかではなくて本当に電柱から電気を取るタイプに結局した方がいいんじゃないかなと思ってしまってるところですね。

そうなんですよね。電源問題も技術的に相変わらず乗り越えられないんだよな。

おっしゃる通り市街地だったら近くの電源から取った方が結果的に運用コストが下がるから小売店地3年間って全然嬉しくないって言われるんですよね。

遠隔地にあればあるだけいいかと言われると、おっしゃる通り回収コストとか一気に電池を交換しなきゃいけないコスト、

これも形状的に電池交換がそもそもできない形状な気がするし、

その辺の回収コストとか考えたらやっぱり電池は向いてない。何なら10年くらい動いてもらうと困るみたいな世界なんですよね。

発電源を設けるかって言ったら大体太陽光とかになるんですけど、

小さい小型機器の太陽光って耐光性がないというか、屋外貯金運用に耐えれるものがないので、

それも下手ってしまうし、なかなか組み合わせがいいのがないんですよね。

そうですね、というところなんで。悩ましいところですけど、先ほど言った通り選択肢が減るのはいいかなと思うので、頑張ってほしいと思います。

やり続けることは賛成だと思います。

LPWA自体がなかなか日本国内で普及しきらずにずっと低迷してるっていうのはちょっともったいない気がするんですよね。

せっかく無線帯として無免許でやっていいっていう、いろんな企業が参戦しやすい土壌を政府として整えたにもかかわらず、

ほぼ誰もLPWAに関心がないっていう現状はもったいないと思うので。

追い風の話で言うとですね、以前そのAWSとかがクラウドの中でローカル5Gのサポートも始めましたよみたいな話あるとも言ってたと思うんですけど、

実はそれより3年くらい前からですね、ローラ1とかこのSIGFOXに対してはAWSのサポートを受けられるんですよ。

なので例えば今回で言うとSIGFOXがKyoceraと連携しなきゃいけないのでKyoceraに繋がるんですけど、

その後自分たちとしての認証システムに転送し直してもらって、認証を通して自分たちのデータとして扱うっていうフローをAWSが組めるようにしてくれてたりするので、

そういった意味で外堀りはちゃんと生まれつつあるから、コアとなるセンサーとか無線モジュール、発電機器、この辺りが何か一つでも揃うとまた少し盛り上がれる土壌はあるのかなと思ってますね。

難しいけどそうですね。企画頑張ってて通信関係も頑張ってるけどなんかハードが追いつけてないのがちょっともどかしい感じがありますね。

もったいないなと思ってしまいますね。

そんな感じでした。

じゃあ私のほう最後ですね。

テンストレントのAI半導体開発

CPU内蔵のAIコンピューターこそが最適解、天才自分キャラが語ったAI半導体の方向性ということで、

テックプラスの記事です。

Apple iPhone 4に搭載されたA4やiPhone 4SのA5、AMDのK7やK8、全アーキテクチャを手掛けるなど天才エンジニアとも呼ばれるジムキャラ氏同士がCEOを務めるテンストレントはAI半導体分野で注目を集める存在となっている。

そんなジムキャラ氏が6月20日に開催されたリスクファイブデイ東京2023サマーの招待講演のために来日、

併せてメディアブリーフィングを実施し、

同社の現在とこれからの方向性、AI半導体に対する考え方などの説明を行った。

ということで、最近のAppleのM2 ProとかUltraの話しかり、NVIDIAの話しかり、

AIに関してのCPUとGPUアーキテクチャの統合みたいな話がいろいろ出つつある中で、

そういった半導体チップが必要だよねってことで、

それの専用会社をジムキャラさんは、いつだったかな、2016年とかだったかな。

だいぶ前にテンストレントという企業を立ち上げてやっておられましたと。

そのチームの中ですでにAIチップっていうのを2種類ほどなされてるんですけど、

今後どうなってくるんですかという話が講演としてありましたと。

RISC-VベースのCPUコアとの組み合わせ

一番のポイントは、RISC-VベースのCPUコアとAIアーキテクチャを動かすアクセラレーターの組み合わせですと。

RISC-Vという選択肢がここで上がってきているのが、

CPU半導体業界としての注目どころになっていて、

RISC-Vはオープンソースで使えるCPUアーキテクチャで、

実行コードが非常にシンプルなものになっていることが特徴なものですね。

FPGAでRISC-Vを組んでみたとか、

一時期、いろんな形でRISC-Vをとりあえず使ってみて、

あれできないか、これできないかが流行っていったり、

中国のベンチャーソック企業がこぞってRISC-VによるCPUソックを出してきたりとか、

いろんな二次流はあったんですけれども、

現在はそのAIの登場によってGPU関係とか、

機械学習AIをいかに早く回せるかという方に注目が集まっていて、

ちょっとRISC-V自体の話がトーンダウンしていたんですけれども、

ここに来てまたテンストレンドさんは、

引き続きRISC-VでAIとの連携を進めていくという発信をされたので、

改めてRISC-Vが注目されるきっかけになるんじゃないかなというところです。

RISC-Vを選んでいる一番の理由としては、

昔からあるダツインテル、ダツアームというところに注力されているので、

もしかするとこのテンストレンドさんの行く末としてある姿としては、

RISC-Vの安価なライセンスモデルということによる、

安価なAIチップという方向性で登場してくるかもしれないです。

先日からAIの軽量化みたいな話をしていたので、

もしかするとある敷地を割った最小化、最適化というのがAIモデルとして登場してきたときに、

そのモデルを動かす最小限のコストパフォーマンスの良いチップという選択肢を探したら、

結果的にこのテンストレンドになるということは十分あり得る世界かなと思っていて、

このジムケラーさんもそういった市場を狙ってそうなので、

ある程度AI技術が枯れてきて、実際自分たちの基盤だったりとかシステムアーキテクチャに

かなり低いレイヤーから組み込んだ商品作りをしていこうといった戦略を

自社として持ちそうだなと思う企業にとっては、

インテルやアップルが出すようなチップではなくて、

こういうメーカーのチップの方が注目ところとして高いのかなと思ってますという紹介でした。

RISC-Vの注目度

AI用と向けの半導体チップがあった方がいいよねっていうのはもう明白な話であって、

それでリスク5コアとアイノリと組み合わせて使うことを考えられるというのは、

確かに言ってた通りインテルとAMDに依存しないという意味では、

とても方向性としては正しいですけど、

一つ気になっているのが結局のところソフトウェアが最適化しようかなって思うほどシェアを取らないと、

多少あっても結局使えないかなってなっちゃいそうなところがちょっと気になるなと思ってますね。

なのでこの文章の後半でも書いてありますが、

結局NVIDIAのグラブ上で動かすようにソフトウェアができちゃってるんで、

選択肢としてはあっても結局みんな使わないねってなっちゃわないようにする戦略がどうすればいいのかなって難しいなと思いながら聞いてました。

ある時点でキラーハードウェアが出てこないと勝てないでしょうね。

例えばですけど、先ほどWindowsコパイロットがWindows作業を行う上でのもうなくてはならない協力関係みたいな感じのコパイロットとして私説明しましたけど、

スマートフォン以外に人間がつけるハードウェア機器として同じようなものが求められる社会に仮になった時にはあった方がいいんじゃないですかね。

NVIDIAが全てのAIが欲しい用途向けのチップを出せるかっていうとそれはまた難しい話なので、

ある種の日用用途向けとかでシェアを広げて、意外と使いやすいじゃんって思ってもらって、

さらにNVIDIAのパイを作っていけたら確かにアリか。

NVIDIAのメインの稼ぎはもうほとんどクラウドによっていて、データセンター用の特化されたもので、

プレゼントがゲームでこんなものが動きますみたいなプレゼンはほとんどなくて、

これくらいのレベルのAIの学習とレンダリングが同時にできるんですよみたいな感じで、

AIがメインでありつつレンダリング能力も高まってますよみたいな、

そういう位置づけに変わりつつあるんですよね、NVIDIAの説明が。

そうするとその先にあるのは大企業としてそのAIをふんだんに活用したい最先端企業に

クラウドを通してアプローチするという世界になるので、

個別のハードウェアへの実実装向けのものはなかなか出さないだろうと思われますと。

一方で現状の市場を見てみると何が行われているかといったら、

NVIDIAの組み込みボード、ラズパイみたいな小さいボードは出してたと思うんですけど、

あれを無理やり自前の商品に組み込んでできるようにしましたみたいな、

そういう組み込み機器以外ほぼ出てなくて、

FPGAで多少の小さいエッジ的な画像解析はできますみたいなレベルの

そういうしょぼい商品しか正直出てなくて、

しかもその先の成長も展示会を見る限り5,6年くらい変わってないという悲しい現実があるので、

NVIDIAが目指してないところは停滞しているという現状が今もうあるんじゃないかなという気はしてますね。

なるほど。それを考えると、

流行りだからやってみたいけど、物がないからできないという潜在的な需要はかなりあると。

そうですると、

そこにじゃあありますよって言ってお出ししてくれると、

かなり使いたい側としては嬉しいので、

そびついてくれると。

じゃないかなと私はなんとなく思ってますけど、

搭載されているAIのレベル

東大さん目線でも周囲に出ている組み込み機器じゃないですけど、

小型ハードウェアの搭載されているAIのレベルって全然成長がないと感じません?

確かに言われてみるとそうですねというところはありますね。

音声認識が賢くなりましたとか、いろいろ言ってるけど、

クラウドにアップロードしているばっかりで、組み込みエッジで賢くなっているものがなくない?という感じがして。

確かにそうですね。

そっち側のクラウド側にアップして接続性を高めてどうのっていうのは見てますけど、

それも確かに昨今の流行りからするともうちょっとねっていうところもあるのでね。

そうそうそう。

なのでこういう会社が意外とどこかでブレイクスルーするんじゃないかなと思っていて、

ただおっしゃる通り今では知名度と普及力の関係からこれに合わせたチューニングがちょっとってなるのはおっしゃる通りだと思うんで、

この機器を組み込んだからこそできる人間の普段の生活をコパイロットするような、

そういうみんなが持ち歩くハードウェアみたいなのが登場したら一気に普及するんだろうなと思ってるって感じです。

そうですね。

はい、以上です。

では次、ITメディアニュースさんの記事です。

Vixion 01とは

目のピント合わせを外部デバイスにアウトソースしてきたら未来が広がった。Vixion 01を体験してきた。タイトルの記事です。

メガのレンズで有名な方やから2021年にスピンアウトしたスタートアップ企業のVixion。

同社が6月29日からクラウドファンディングを始めたのが、新製品のオートフォーカスアイウェアことVixion 01だ。

Vixion 01は、眉間の部分にある距離センサーで見ているものとの距離をリアルタイムに計測し、

両側のレンズの膨れみを変えて焦点を合わせるウェアラブルデバイス。

フォーカスがあれば人間の目には風景がくっきりと見えるようになる。

Vixionの南部社長は、人の目はレンズの役割を持つ水晶体の厚さを模様体で動かしてピントを合わせる。

Vixion 01はそのピント調節機能をアウトソーシングするようなもので、目は疲れないと説明している。

ちょっと長いのでここからかいつまみますけど、

弊社の方が体験してみたところ、スーッという感じでフォーカスが合うということで、

一瞬で合うというよりはちょっとタイミングがあるというところはありますけど、

部屋の奥とか手前とかがぴったり合うというところは、ちゃんと綺麗にできていると。

イメージとしてはデジカメのオートフォーカス並みの速さで音もなくピントが合うというところで、

Vixion 01の使い道

未来のメガネといったフレーズが浮かんでくるような斬新な新鮮な体験ということが得られるそうです。

ただ視野が広くメガネを代用できるものではないということで、

南部社長を曰くメガネを期待しないでほしいというところが今の機能上の制限らしいです。

現状想定されているところとしては、細かい作業を長時間する人、

例えば模型作り、ハンダ固定を使った電子工作、PCで長時間原稿を書く人などを想定しているということで、

確かにそこら辺だったら使い勝手がいいのかなというところです。

最後、今後の見通しとして、特定用途に向けたプロ用製品をいくつか出すこと、

そして今後1〜3年のうちに現在より大きなレンズを使った製品を従事投入する考えを明らかにしている。

レンズ系はいずれ現在の2倍にできる見通しだということから、

より汎用的な製品を望むのならばしばらく待ってもいいかもしれないというところで締められています。

柔道のメガネユーザーとしてはやっぱりこういうものがあったらいいなというのが実現されている。

ほうやさんが作られているので機能的にもしっかりしていて面白いなというところでの紹介です。

素直に素晴らしいし、これをきっかけに競合がいっぱい出てきて戦ってほしいなと思うばかりですね。

デザインとか目的のユースケースもありますけど、

そこまでの追従性はなくてもいいからゆったり使いたい人向けとか、

もっとB2C向けなものも出すメーカーがいてほしいなと思うのでそういうのに期待しますが、

いろいろ読んで一番思うのは早くVRゴーグルに導入されてほしいというところですかね。

あれ実際どうなんですかね。分かりますよ。

メガネつけずにピント合わせてほしいっていうのはそうなんですけど、

VRゴーグル上でメガネをつけないとピントが合わないっていうことは、

VRゴーグル内で人間がピントを遠くにしたり近くにしたりしてるわけじゃないですか。

そこに対してこれを乗せた時にたぶん現在のハードウェアの制約上ちょっと遅延があるので、

めちゃくちゃ酔っちゃうんじゃないかなと思いながら読んでたんですけどどうなんでしょうね。

あー逆にか。それはそうかもな。

そうですね。応答性がある程度ないと厳しいかもしれない。

人間のピント合わせ能力と同等レベルに追従できる能力がないと厳しいのかもしれないですね。

ただVRゴーグルだと多少電源がガバでもいいというかVRゴーグル自体が消費電力が高かったりするので、

もっと現状よりも大電力だけど応答性の速いパワーに振ったレンズみたいなのが出てきてくれると、

そこらへん酔わずに使うことができるようになるとうれしいかなと思ってます。

そうですね。個人的にはこれ、健常者もありがたい機能なんじゃないかなと思ってるんですよ。

VRゴーグルで目が疲れる問題ってやっぱりあるんで、少しでも目の負担を軽減する策としてもいいと思いますし、

例えば車に乗るとき、目の疲れとかピントを合わせるのに時間がかかってしまって、

なかなか判断が遅れるっていうことはやはり事故防止の観点からも防ぎたいはずですし、

健常者を助ける意味でもすごく役に立つんじゃないかなっていう期待感があるんですけどね。

そうですね。携帯を見るときに老眼の人でパタパタしてる人とかもいると思いますし、

普段メガネかけていない人でも手先に集中する仕事とかで目が疲れてしまうというところ。

多分手元によるような作業ですよね。手元にピントを合わせてずっと作業するようなところとかだと、

こういうのがやっぱり効いてくるんじゃないかなというところ思うところですね。

そうですね。本当に今のままだといろんな指でぶっちゃけ使い物にならないと思うんですよ、これ。

レンズがあまりにもちっちゃすぎますし。ただ本当にこの社長さんが言ってた通りで、

夢のある目のピントが勝手に外部で合ってくれるという期待感が高すぎるんだと思うんですよね、市場から。

なのであえてこういうものを出して実績を積んでいかないといけないっていうのをおっしゃる通りだと思うんで、

本当にこのニュースを見て、実は今まで研究ベースですごい高い完成度を狙ってて頑張って商品化にこぎつけようとして、

なかなか仕上がっていかないって苦しんでた企業は負けじと今のレベルでいいからとりあえず商品化出すかっていうふんぎりに変わってほしいなと思いますね。

そうですね。そこら辺も含めてスピンアウトしてクラウドファンディングでやっているとも一応書かれているんで、

そこら辺も多分社長さんも分かっているところもあると思いますけど、私の個人的な印象としては使ってみるとわからないともありますけど、

先ほど言っていたハンダゴテを使った電子工作や模型作りとかだと現状でも結構使えそうだなという気はしていて、

実体験としてやっぱり細かいところを見るときに限界だからっつって結構ルーペを使ったり、角度割り率低いですけどとかを使ったりすることもなくはないんですよね。

そういう用途って結局そのルーペ状のしかも中央部分ぐらいしか焦点が合わない状態で使ってたりするんで、

そういうところにこのメガネをつけることでピタッと合う、加工面だけをピタッと見たいみたいなことをする作業であれば結構需要があるのかなというか使い出があるのかなという気はしていますね。

確かに。

今の話聞いて確かにとめっちゃ思ったのはあれだな。

ハンド対実装現場の作業者の外観検査者にこれつけてほしいね。

そうですね。

そういう用途だと結構あるんじゃないのかな実はというところはあって。

確かに。

めっちゃわかります。

なるほどね。

というところなんで、やっぱり物があったら結構使ってくれ、使いたいという潜在的な需要はあるんじゃないのかなという気がしているのでかなり思いましたね。

そうですね。

いいなあ。

なんかそのうちこういうデバイス増えすぎて首掛け式のバッテリーをみんなかけてるのが当たり前みたいな世界にならんかな。

まあそれも面白いかなという気がしますけどね。

前回でしたっけ前々回でしたけど結構やっぱVRゴーグルとかバッテリー充電するの大変だから展示会とかで倍持ってるみたいな話もしてましたけどそういうのと一緒で結構使いたいときに電池切れしてるとめんどくさって思うぐらいまでいくといいなという気がしますしそうなったときに首からバッテリーをかける。

全部USB-Cで接続するという未来は結構面白いですね。

イメージしてたのが昔からあるスチームパンク的なエンジニアの姿で片耳だけモノクル的にルーペをつけるみたいなのがあるじゃないですか。

それにこれはかなり良いなと思ってて。

普段から常時したいわけでもないしガッツリメガネを外してこれに切り替えたいわけでもなくて今一瞬ここを集中してみるのに使いたいみたいな。

そうですね。そういう用途でかなり実用性はあると思いますし。

いいね。確かに確かに。

このレベルでもとりあえず商品化してユーザーがあれに使えないかなっていうことを起こすこと自体が市場に対する良い行動だと思うんで。

先駆者として素晴らしいな、そういう意味だと。

はい、というところで頑張ってほしいというところです。

じゃあ今日こんなところですかね。

はい、本日の内容はショーン.でまとめていますのでご確認ください。

リカログではご意見ご感想やこんなことを話してほしいという応募もお待ちしています。

本番組はPodcast、Spotify、YouTube、ライブ、あとリッスンで聞くことができます。

ぜひそれぞれもサブスクライブよろしくお願いいたします。

はいではお疲れ様でした。

はいお疲れ様でした。